اگر به هوش مصنوعی (AI) علاقمندید و این خبر بزرگ را در ماه جاری نشنیدهاید. مثل این است که از یک اتفاق مهم بیخبر بودهاید. همهچیز دارد تغییر میکند!

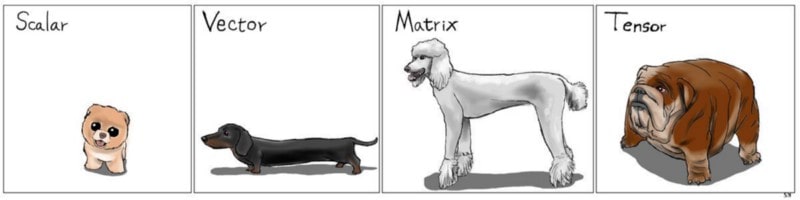

سال قبل مقالهای در مورد 9 نکته در مورد تنسورفلو منتشر شد، اما الان تنها یک چیز لازم هست که بفهمیم: تنسورفلو 2.0 اینجاست!

انقلابی در راه است! به تنسورفلو 2.0 خوش آمد می گوییم.

این یک تغییر اساسی است. عواقب ناشی از آنچه اتفاق افتاده، اثرات عمده ای بر روی هر صنعت می گذارد. فقط منتظر بمانید. اگر شما در اواسط سال 2019 یک مبتدی در کار با TF هستید. به خاطر اینکه شما بهترین زمان ممکن برای ورود به AI را انتخاب کردید، فوق العاده خوش شانسید. (ممکن است بخواهید از ابتدا و نسخه ی قبلی TF شروع کنید، اگر آموزشهای قدیمی که شما مطالعه میکنید کلمهی “session” را داشته باشد).

به طور خلاصه: TensorFlow به طور کامل به سمت Keras رفته است. کسانی معنی این اتفاق را می دانند، بسیار متعجب شدند. بوم!

تنسورفلو توانمند است!

توانمندی هستهی تنسورفلو در کارایی آن است. تنسورفلو مدلها را از تحقیق به تولید در مقیاس وسیع میگیرد و تحویل می دهد. اما با TF 1.x برای کارها عرق میریزید. بنابرین اگر شما پشتکار داشته باشید میتوانید به دسته ی متخصصان ML که از چیزهای باورنکردنی مانند کشف سیارات جدید و پزشکی پیشگام استفاده می کنند، بپیوندید.

چه حیف که چنین ابزار قدرتمندی تا به حال در دست چند نفر بوده است.

کراس جذاب و راحت

Keras یک مشخصه برای مدلسازی لایه-به-لایه است که با چارچوبهای مختلف کامپیوتری کارمیکند (این چیزی نیست که اختصاصی متعلق به TF باشد). اما شما ممکن است آن را به عنوان یک API سطحبالا بشناسید. این API از طریق TensorFlow با عنوان tf.keras شناخته میشود.

چرا ما هر دو را نداریم؟

چرا باید بین کراس و تنسورفلو انتخاب کنیم؟ چرا ما هر دو را نداریم؟

ایده ی خوبی است! بیاید که این دو ابزار را داشته باشیم! این اتفاق تقریباً در تنسورفلو 2.0 رخ داده است.

قابل استفاده بودن

مقداری جلوتر میرویم. Keras چهارچوب سطحبالا برای TensorFlow بوده و تواناییهای آن را گسترش خواهد داد. بنابرین شما میتوانید از تمام ویژگیهای پیشرفتهی TensorFlow به طور مستقیم از طریق tf.keras استفاده کنید.

تمام تنسورفلو یه همراه سادگی کراس در هر مقیاس و با هر سخت افزاری قابل استفاده است.

در نسخه جدید، همه مواردی که در TensorFlow 1.x محبوب و خوشایند نبودند، حذف شدند. دیگر نیازی به انجام تشریفات فقط برای اضافه کردن دو عدد با هم؟ نیست، و پایان یافت. جلسات TensorFlow؟ به پایان کار خود رسیدند. یک میلیون راه برای انجام یک چیز؟ به پایان کار خود رسیدند. کد بازنویسی که برای تغییر سخت افزار یا مقیاس؟ به پایان کار خود رسیدند. Reams از boilerplate برای نوشتن؟ به پایان کار خود رسیدند. پیام های خطای ناخوشایند وحشتناک؟ به پایان کار خود رسیدند. منحنی یادگیری؟ به پایان کار خود رسیدند.

تنسورفلو به پایان کار خود رسید، شما می توانید با تنسورفلوی 2 به کار خود ادامه دهید!

! TensorFlow is dead, long live TensorFlow 2.0

استفاده از eager

در تنسورفلو 2.0، اجرای حریصانه یا eager execution به صورت پیش فرض فعال است. شما میتوانید از گراف ها حتی در زمینه eager استفاده کنید، که باعث می شود اشکالزدایی و نمونهسازی شما آسان باشد. در حالی که TensorFlow runtime برای عملکرد و مقیاس در backend مراقبت میکند.